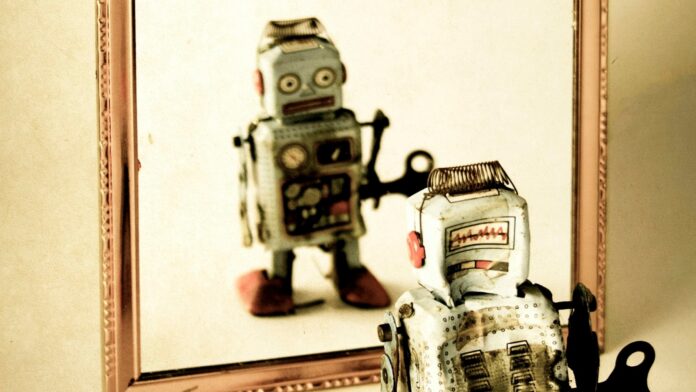

L’intelligenza artificiale sta rapidamente diventando più capace, ma manca ancora un elemento chiave dell’intelligenza umana: la consapevolezza di sé. Gli attuali sistemi di intelligenza artificiale generativa come ChatGPT funzionano senza comprendere i propri livelli di confidenza o riconoscere quando sono incerti. Questa carenza può avere gravi conseguenze in settori ad alto rischio come la medicina, la finanza e i veicoli autonomi. È in fase di sviluppo un nuovo quadro matematico per affrontare questa limitazione consentendo all’intelligenza artificiale di monitorare e regolare i propri processi “cognitivi”, dandole essenzialmente un monologo interiore.

L’essenza della metacognizione

La capacità di pensare al pensiero, nota come metacognizione, è fondamentale per l’intelligenza umana. Implica riconoscere quando un processo di pensiero non funziona e adattarsi di conseguenza. Fino a poco tempo fa, i sistemi di intelligenza artificiale erano in gran parte inconsapevoli di questa capacità. I ricercatori stanno ora lavorando per cambiare la situazione progettando un’intelligenza artificiale in grado di valutare la propria sicurezza, rilevare la confusione e decidere quando concentrarsi più attentamente su un problema.

Perché le macchine hanno bisogno di consapevolezza di sé

L’intelligenza artificiale di oggi genera risposte senza sapere quanto siano affidabili. Nelle applicazioni critiche, questa incertezza può portare a risultati pericolosi. Ad esempio, un’intelligenza artificiale medica potrebbe suggerire con sicurezza una diagnosi senza riconoscere sintomi contrastanti o riconoscere quando è necessaria la competenza umana.

Lo sviluppo della metacognizione richiede sia autoconsapevolezza (monitoraggio del ragionamento) che autoregolamentazione (controllo delle risposte). I ricercatori hanno creato un vettore di stato metacognitivo, che quantifica lo stato cognitivo interno di un’intelligenza artificiale in cinque dimensioni:

- Consapevolezza emotiva : per prevenire risultati dannosi monitorando contenuti carichi di emozioni.

- Valutazione correttezza : misura la fiducia dell’IA nelle sue risposte.

- Corrispondenza esperienza : controlla se una situazione assomiglia a qualcosa che l’IA ha già incontrato in precedenza.

- Rilevamento conflitti : identifica informazioni contraddittorie che richiedono una risoluzione.

- Importanza del problema : valuta la posta in gioco e l’urgenza di dare priorità alle risorse.

Orchestrare i processi mentali dell’intelligenza artificiale

Immagina un ensemble di intelligenza artificiale come un’orchestra. Il vettore degli stati metacognitivi funge da conduttore, monitorando se i “musicisti” dell’IA (modelli linguistici individuali di grandi dimensioni) sono in armonia. Di fronte a un compito semplice, l’IA opera in modo efficiente in modalità “Sistema 1” (elaborazione rapida e intuitiva). Ma quando si confronta con la complessità, il conduttore ordina all’IA di passare alla modalità “Sistema 2” (ragionamento lento e deliberativo), assegnando ruoli come critico o esperto a diversi componenti dell’IA.

L’impatto e il futuro dell’intelligenza artificiale metacognitiva

Le implicazioni vanno ben oltre il miglioramento della precisione. Nel settore sanitario, l’intelligenza artificiale metacognitiva potrebbe segnalare diagnosi incerte per la revisione umana. Nell’istruzione, potrebbe adattare le strategie di insegnamento in base alla confusione degli studenti. Nella moderazione dei contenuti, potrebbe identificare casi sfumati che richiedono un giudizio umano.

Fondamentalmente, questo quadro aumenta la trasparenza consentendo all’IA di spiegare i suoi livelli di fiducia e le sue incertezze. Questa interpretabilità è essenziale per creare fiducia nelle applicazioni critiche. Il lavoro attuale non crea coscienza, ma serve come primo passo verso una metacognizione artificiale più sofisticata. La ricerca futura si concentrerà sulla convalida del quadro, sulla misurazione dei miglioramenti delle prestazioni e sull’esplorazione del metareasoning (ragionamento sul ragionamento) in campi come le diagnosi mediche e il ragionamento legale.

In definitiva, l’obiettivo è quello di creare sistemi di intelligenza artificiale che comprendano i propri limiti e punti di forza, sapendo quando essere fiduciosi, cauti o rimettersi alla competenza umana.